現在第3次AIブームと呼ばれるほど、様々な分野でAIが活用され社会に深く浸透しつつあります。そもそもAI(Artificial Intelligence:人工知能)とは、一般的には人間の知的ふるまいの一部をソフトウェアを用いて人工的に再現したものと定義されています。第3次AIブーム以前のAIは、知的ふるまいをさせるためにコンピュータに「探索・推論」をさせることや、数多くの専門知識を持たせることを人間がプログラミンしたソフトウェアで実現しようとしていました。しかしながら、今日のAIブームほどの発展と普及までにはいたらなかったのです。

ではなぜ今日のようなAIブームが起きたというと、機械学習という仕組みが考案されその考え方をAIに取り入れ、そして「ディープラーニング:深層学習」とよばれる人間の脳のプロセスと非常に似ているニューラルネットワークを用いた機械学習へと発展し、より複雑な判断がAIで可能になったからです。

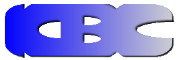

しかしながら、この「ディープラーニング:深層学習」でコンピュータが自己学習しより人間的思考が少しずつ可能となり利用分野が拡大していく反面、自己学習で得られた概念や知識そして思考プロセスを人間が理解できず、AIの判断が道徳的・倫理的にも本当に正しくて信用できるかという問題が表面化してきているのです。これがAIのブラックボックス問題です。

このブラックボックス問題が浮き彫りになった象徴的な事例として、囲碁AI「AlphaGo」が世界トップ棋士を破った対局があります。この対局で複雑怪奇なAlphaGoの打ち筋に、解説者のプロ棋士はもとより、AlphaGoを開発したメンバーでさえも、勝因が分からなかったそうです。AlphaGoは過去の棋譜を元にした「教師あり学習」と、囲碁AI同士を対局させて鍛える「強化学習」のみ行い、囲碁のルールは組み込まれていなかったのですが、プロ棋士でも見つけられないような未知の定石や打ち筋を生み出しました。一般的なソフトウェアであれば、プログラムコードを追いかければ要因が分かりますが、「AlphaGo」のようなAI(ディープラーニング)では、人間が分かる論理コードはなく、コンピュータが自己学習して導き出したアルゴリズムが存在し、このアルゴリズムは人間には理解できないブラックボックスとなっています。なので、この対局においても勝利はしましたが、思考はすべてブラックボックスで行われ結果的に勝因はわからなかったということです。

人命や安全に関わる分野や人道的倫理観が必要とされる分野では、判断や決定にその責任を問われ信頼できる説明が求められます。今後益々AIが進歩したとしても、ブラックボックス問題があるかぎりこれらの分野ではAIの活用は望めないし、その他の分野でも活用が制限されてしまうかもしれません。AIのブラックボックス問題は、今後のAI利用及び発展の大きな課題となってきています。そして、政府が策定した「AIの7つの原則」の中にも、“AIを利用した企業に決定過程の説明責任”が提言されており、社会的にもAIによる決定や判断の過程に対する説明責任が問われる時代になってきています。

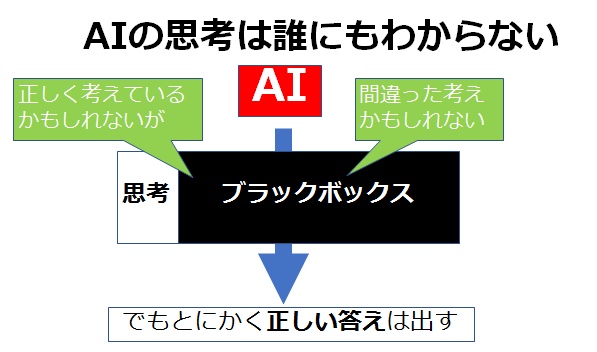

そこで近年、このAIのブラックボックス問題に対してAIのホワイトボックス化のという観点から、XAI(Explainable AI:説明可能なAI)の研究が進められています。

XAIは簡単にいえば、AIによる結果のみならず、その判断に至った過程・理由を人間が理解し検証できるようにしたAIです。

XAIの研究が進めば、ブラックボックス問題によりAIの利用に無かなった人命や安全に関わる分野や人道的倫理観が必要とされる分野への利用拡大が望めるようになると期待されています。

![]()